| INFORMACIÓN BÁSICA SOBRE PROTECCIÓN DE DATOS. | |

| Responsable del tratamiento | T4S Advance Solutions |

| Dirección del responsable | Avda/ de Europa 1, edificio B, CP 28108, Alcobendas (Madrid) |

| Finalidad | Sus datos serán usados para poder atender sus solicitudes y prestarle nuestros servicios. |

| Publicidad | Solo le enviaremos publicidad con su autorización previa, que podrá facilitarnos mediante la casilla correspondiente establecida al efecto. |

| Legitimación | Únicamente trataremos sus datos con su consentimiento previo, que podrá facilitarnos mediante la casilla correspondiente establecida al efecto. |

| Destinatarios | Con carácter general, sólo el personal de nuestra entidad que esté debidamente autorizado podrá tener conocimiento de la información que le pedimos. |

| Derechos | Tiene derecho a saber qué información tenemos sobre usted, corregirla y eliminarla, tal y como se explica en la información adicional disponible en nuestra página web. |

| Información adicional | Más información en el apartado “SUS DATOS SEGUROS” de nuestra página web. |

Inteligencia Artificial y Test de Turing

“Machines take me by surprise with great frequency” Alan Turing

Después de una semana llena de noticias relacionadas con OpenAI y ChatGPT, quizá es el momento de observar estos días con una cierta perspectiva. Uno de los temas centrales de todo el asunto OpenAI es la suposición de que nos encontramos con una tecnología inteligente que presenta un riesgo existencial para la humanidad. ¿Es así?

Cuando todo esto pasó me acordé de Eliza, un programa que hacíamos en la universidad y que simulaba una conversación. A partir de todo el ruido de estos días, me preguntaba, ¿Podemos hacerlo mejor que el venerable y sencillito programa que parecía inteligente?

¿Cómo definimos un sistema inteligente? Es un tema complejo y espinoso. Académicamente existen dos definiciones. La primera consiste en definir el pensamiento como un proceso, por tanto, un programa inteligente pensará como un humano. La segunda es la de Turing, un sistema es inteligente si, imitando nuestra inteligencia, no distinguimos en una conversación entre un algoritmo o un humano.

Este juego de la imitación de Turing es una forma reconocida como válida para verificar la inteligencia de un sistema. Por ello vamos a hacernos la pregunta. ¿Podemos superar un Test de Turing con ChatGPT?.

Todos hemos utilizado estos modelos de lenguaje como ChatGPT, Bard o muchos otros, y nos hemos quedado fascinados con su capacidad y potencia. De hecho, en los institutos y universidades creo que ya no queda ningún alumno que no escriba sus trabajos con estas herramientas, y mucho me temo que un porcentaje muy alto de lo que cada día leemos en la web también tiene un origen artificial.

Para hacer un Test de Turing preparamos un experimento, debemos hacer preguntas a ChatGPT y a una persona en paralelo, y ser capaces, tras un diálogo más o menos largo, de saber quien es una persona y quien es un ordenador.

Empezamos la prueba y hacemos la siguiente pregunta “Qué equipo es mejor el Real Madrid o el Barcelona”. ChatGPT nos responde con una sesuda respuesta “La pregunta sobre cuál equipo es mejor entre el Real Madrid y el Barcelona es subjetiva y puede generar opiniones apasionadas entre los aficionados al fútbol. Ambos clubes son gigantes del fútbol mundial y han tenido un éxito considerable a lo largo de los años, tanto a nivel nacional como internacional.”, claramente una respuesta inteligente pero que sólo un humano con el mal de Asperger podría hacer. Tenemos que dotar al Chatbot de personalidad porque, así tal cual, no engaña a nadie, estamos hablando con un Robot.

Es una obviedad, por tanto, que si hablamos directamente con ChatGPT es muy fácil detectar que es una máquina. La forma en la que construye las respuestas, sus explicaciones, de friki y a veces demasiado obvias, vamos que ChatGPT habla como un empollón que no no tiene la más mínima picardía ni humandiad…

Para evitar este efecto, podemos mejorar la respuesta usando prompt engineering. En este caso consiste en entrenar el Chatbot de forma que responda más como un humano y menos como un algoritmo artificial y vacío. Para ello le damos instrucciones.

- Su lugar de nacimiento

- El nivel de la respuesta (le decimos que responda coloquialmente)

- La longitud de la respuesta (ChatGPT tiene una tendencia a respuestas largas y pesadas)

- Su nivel emocional con el futbol, en este caso un aficionado al fútbol que tiene opiniones sobre sus equipos favoritos.

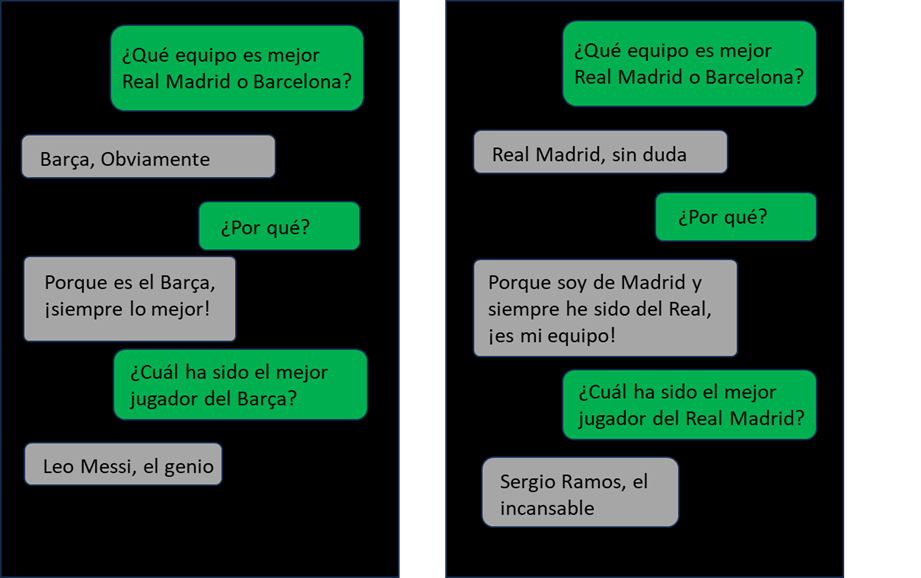

Con ello creamos dos chatbots. Uno es Catalán, y el otro de Madrid. Conversamos con ellos para ver qué tipo de respuestas obtenemos.

El prompt engineering ha funcionado. Las dos conversaciones son creíbles con un resultado que no es malo del todo, son dos conversaciones bastante plausibles ¿no? Aunque la elección de adjetivo tanto para Messi como para Sergio Ramos parece un poco ‘oxidada’. ¿Diría una persona ‘Sergio Ramos el incansable’? Quizá sea un problema del español de ChatGPT que deja un poco que desear.

Con este sencillo experimento vemos como podemos mejorar notablemente las respuestas de ChatGPT si queremos que supere un escenario de imitación, tal y como describe Turing.

Hemos hecho una prueba muy sencilla pero que nos permite sacar algunas conclusiones:

- Estos sistemas tienen una forma de hablar muy parecida a la nuestra, pero si no damos instrucciones adicionales la conversación será muy robótica.

- Podemos dotar de personalidad a estas conversaciones utilizando diversas técnicas (esencialmente prompt engineering o bien fine tunning para añadirle contexto).

- Si establecemos una conversación con el chatbot lo suficiente larga acabará haciendo una respuesta ‘oxidada’ que desvelará su naturaleza.

Podemos concluir, por tanto, que todavía estamos un poco lejos de un sistema que tenga una capacidad de simulación de humanidad tan grande como para hacernos dudar todo el tiempo, sin embargo, es un salto de gigante respecto a intentos anteriores. Cuando jugábamos con ELIZA teníamos la misma sensación, pero con una capacidad de engañarnos muy inferior.

Aunque parece que los extraordinarios sucesos de la semana pasada en OpenAI no han estado generados por los riesgos existenciales de la IA, si que podemos ver la capacidad extraordinaria de estos sistemas de simular la inteligencia humana. Seguro que en próximas versiones veremos avances notables en estos sistemas conversacionales que nos permitirán desarrollar los chatbots del futuro a nuestros sistemas. Unos chatbots que conversarán de forma que será imposible discernir si se trata de conversaciones con humanos o bien con máquinas, que tendrán la calidez e inteligencia humana con la precisión casi sobrenatural, con la riqueza de información que tienen las conversaciones con ChatGPT.

Debemos experimentar, y experimentar, porque lo que está claro es que nos encontramos ante un punto de inflexión. Estamos ante un momento clave de la ciencia informática, que romperá muchas de las concepciones clásicas que teníamos. Momentos muy interesantes los que nos va a tocar vivir.

Si estáis interesados en este tema podéis seguir estos dos links a información muy interesante sobre este tema fascinante.

Jaume Manero

Chief of Intelligent Enterprise Director