| INFORMACIÓN BÁSICA SOBRE PROTECCIÓN DE DATOS. | |

| Responsable del tratamiento | T4S Advance Solutions |

| Dirección del responsable | Avda/ de Europa 1, edificio B, CP 28108, Alcobendas (Madrid) |

| Finalidad | Sus datos serán usados para poder atender sus solicitudes y prestarle nuestros servicios. |

| Publicidad | Solo le enviaremos publicidad con su autorización previa, que podrá facilitarnos mediante la casilla correspondiente establecida al efecto. |

| Legitimación | Únicamente trataremos sus datos con su consentimiento previo, que podrá facilitarnos mediante la casilla correspondiente establecida al efecto. |

| Destinatarios | Con carácter general, sólo el personal de nuestra entidad que esté debidamente autorizado podrá tener conocimiento de la información que le pedimos. |

| Derechos | Tiene derecho a saber qué información tenemos sobre usted, corregirla y eliminarla, tal y como se explica en la información adicional disponible en nuestra página web. |

| Información adicional | Más información en el apartado “SUS DATOS SEGUROS” de nuestra página web. |

¿Se parecen los Grandes Modelos de Lenguaje a un Camello?

¿La historia de los Grandes Modelos de Lenguaje es un Camello con cuello de girafa? Y ¿Es la IA un Bálsamo de Fierabras empresarial?

Un momento clave en el mundo de la computación fue cuando el supercomputador Deep Blue de IBM derrotó a Kasparov en un evento clave de la lucha insomne Hombre-Máquina, esta vez, ganando la máquina. IBM nos volvió a impresionar en 2011 cuando su nueva creación, Watson, derrotó a los mejores jugadores de Jeopardy, en una espectacular sesión que nos hizo soñar (y a Warren Buffet que puso 11.000 millones de dólares en la empresa).

Watson fue la culminación de varios años de investigación y un esfuerzo considerable para aplicar complejos algoritmos de machine learning a la comprensión del lenguaje natural, con unos resultados que pulverizaron cualquier precedente. El resultado hizo soñar a los expertos en inteligencia artificial, ofreciendo un camino para lograr el elusivo objetivo para las máquinas de comprender toda la complejidad del lenguaje natural.

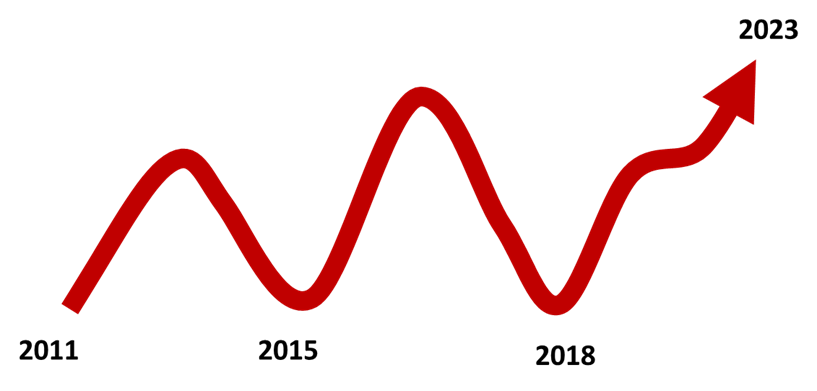

Por un momento el problema parecía bien encaminado, aparecieron aplicaciones interesantes, pero rápidamente el enfoque puramente basado en machine learning mostró sus limitaciones. Esta fue la primera joroba. El interés y la atención descienden de golpe dibujando la primera joroba de atención en la comprensión del lenguaje natural, este no era el camino (y Warren Buffet sigilosamente desinvirtió su posición gigantesca en IBM..)

Cuando ya parecía que el problema es irresoluble, Deep Learning acudió al rescate. El descubrimiento del poder de los embeddings y la efectividad de las redes neuronales recurrentes generó otro momento de esperanza. De nuevo disponíamos de herramientas que nos acercaban al objetivo de la comprensión del lenguaje natural. 2017 fue un momento exuberante para las startups de lenguaje año en que se multiplicaron ofreciendo promesas de chatbots imposibles hasta entonces. Pero la joroba aparece cuando estas redes neuronales mostraron sus limitaciones a comprender el contexto, se perdían con contextos largos (habéis oído hablar de los gradientes que desaparecen, la enfermedad de las Redes Recurrentes), de nuevo, el lenguaje natural muestra su descarnada complejidad ante los ataques de los algoritmos de redes profundas. Aquí viene la joroba y la decepción.

Pero los grandes descubrimientos aparecen en momentos insospechados, y acostumbran a ser elegantes y bellos, así cuando un pequeño articulo de Google llamado ‘Atención es todo lo que necesitas’ describe una técnica, la atención, que permite mejorar el entendimiento del contexto en redes neuronales. Los más visionarios (OpenAI, Google, etc) entienden su importancia iniciando la imparable carrera de los grandes modelos de lenguaje. BART, GPT y un largo etc, que a medida que crecían demostraban su robustez y capacidades que están revolucionando, no solo el mundo de la inteligencia artificial sino cualquier campo en el que se aplican.

Esta es la metáfora de las dos jorobas. Ahora estamos en el momento más interesante de la historia en el campo del reconocimiento del lenguaje natural, y creo, que aquellos que estamos intentando contribuir humildemente en este campo, pensamos que esta vez no tendremos tercera joroba, que esta vez, la tecnología de los grandes modelos de lenguaje no tendrá un final abrupto. Seguro que veremos nuevos elementos que nos harán llegar más lejos y más alto, pero esta vez no hay vuelta atrás.

Nuestro camello tiene solo dos jorobas y ahora está creciendo hacia el cielo.

Jaume Manero

Chief of Intelligent Enterprise Director